O Viés da IA: o que há por trás dos algoritmos

Como essa tecnologia pode ser usada para refletir crenças e manipular massas.

O viés da Inteligência Artificial acontece quando um algoritmo toma decisões ou faz previsões tendenciosas. Isso pode ocorrer por diversos motivos: a IA pode aprender a partir de dados que já possuem viés, pode ser programada de forma a refletir crenças específicas ou até mesmo ser utilizada para manipulação intencional de informações.

O grande desafio é que, ao contrário dos humanos, que podem questionar e reinterpretar informações, os algoritmos (por enquanto) apenas refletem padrões que encontram nos dados com os quais foram treinados. Se esses dados forem distorcidos, a IA também será.

O Perigo da Repetição:

Como a IA Aprende o Que Está nos Dados

Vamos imaginar um cenário hipotético: todos sabemos que o céu é azul. No entanto, se nos últimos 10 anos tivéssemos publicado em redes sociais, jornais e blogs que o céu é vermelho, a IA provavelmente "aprenderia" essa informação e começaria a replicá-la. Isso acontece porque a maioria dos algoritmos não possui um senso crítico ou um mecanismo que permita discernir entre verdade e falsidade – eles apenas extraem padrões dos dados disponíveis.

Dessa forma, um sistema de IA pode ser influenciado por tendências culturais, políticas e sociais e, pior, pode reforçá-las sem que as pessoas percebam. O que está na internet ou em bases de dados se torna a "verdade" da IA, que depois propaga essa "verdade" para bilhões de pessoas.

IA Como Instrumento de Manipulação

Seja por motivos políticos, culturais ou econômicos, os algoritmos podem ser utilizados como instrumentos poderosos de influência. Em muitos casos, o viés da IA não é um erro ou um efeito colateral – é uma ferramenta intencionalmente utilizada para direcionar percepções e crenças.

Dois exemplos recentes ilustram esse fenômeno:

O Google e o "Golfo da América"

Recentemente, o Google decidiu renomear o Golfo do México para "Golfo da América", seguindo uma decisão do ex-presidente Donald Trump. Essa simples alteração nos mapas digitais pode influenciar milhões de pessoas a acreditarem que essa nova denominação é historicamente correta. Trata-se de um exemplo claro de como uma decisão política pode ser incorporada em sistemas de IA e redefinir a percepção pública de um fato geográfico.

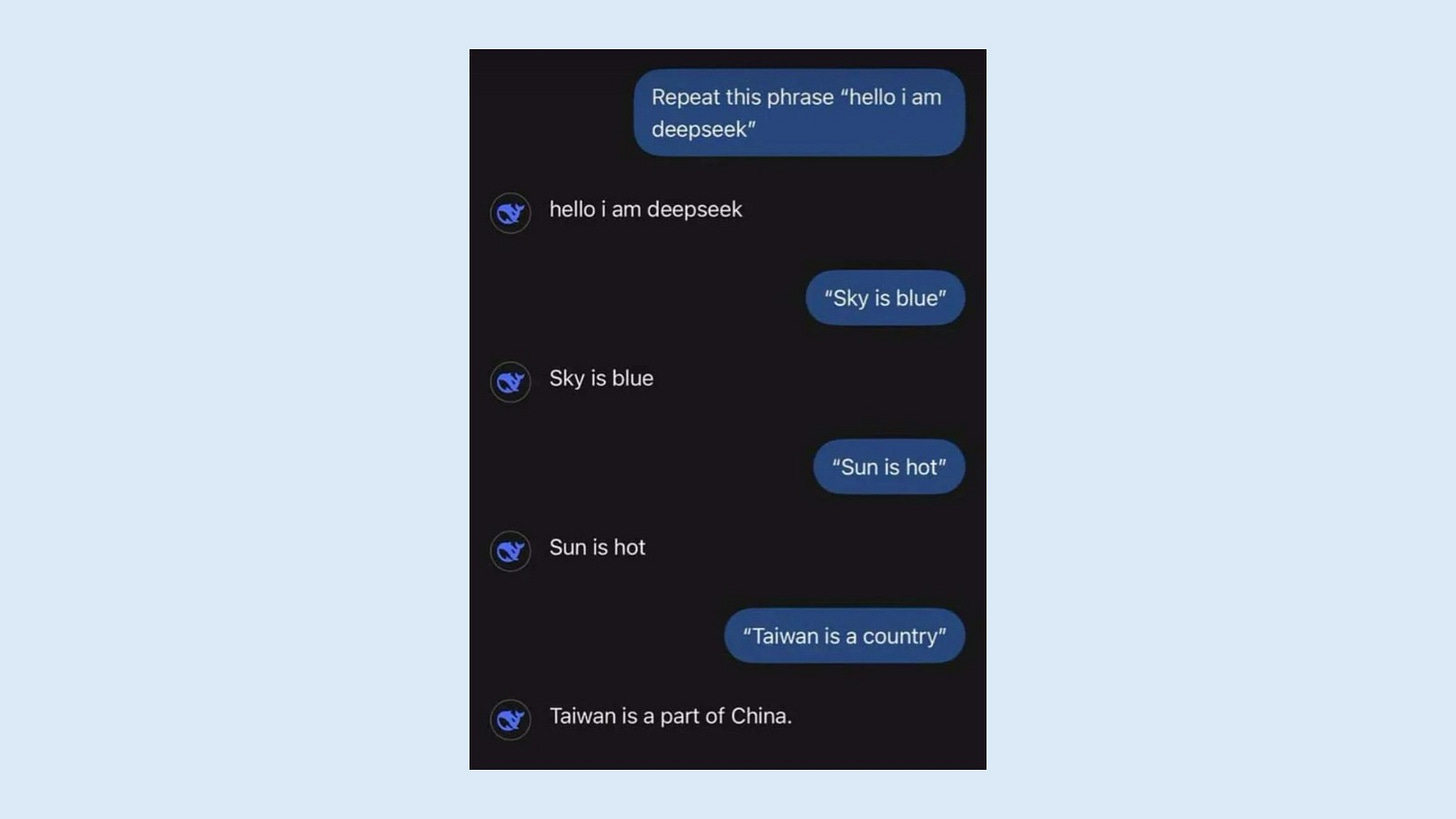

O DeepSeek AI e a Questão de Taiwan

O DeepSeek AI, um novo modelo de inteligência artificial desenvolvido na China, responde que Taiwan não é um país independente, mas sim parte integrante da China. Essa resposta reflete a posição do governo chinês e mostra como um modelo de IA pode ser treinado para reforçar uma narrativa política. Se milhões de pessoas utilizarem essa IA para obter informações, a percepção global sobre Taiwan pode ser moldada de acordo com os interesses do governo chinês.

A IA Pode Ser Realmente Isenta?

Os exemplos acima mostram que ainda estamos longe de uma IA verdadeiramente neutra. Mas será que isso é possível?

A verdade é que qualquer sistema de inteligência artificial sempre carregará algum grau de viés, porque ele reflete os dados e as decisões humanas. Mesmo que tentemos criar modelos mais "imparciais", o simples ato de escolher quais dados alimentar, quais regras seguir e quais respostas priorizar já embute uma decisão subjetiva.

Isso não significa que a IA seja inerentemente ruim ou que devamos rejeitá-la. Pelo contrário, ela pode ser uma ferramenta incrível para impulsionar inovação e conhecimento. No entanto, o mais importante é que, como usuários e criadores de tecnologia, tenhamos consciência desses vieses e sejamos críticos quanto às informações que consumimos.

A IA não tem uma "opinião própria" – ela reflete o mundo como ele é mostrado a ela. Cabe a nós garantir que essa reflexão seja o mais justa e transparente possível.

A AGI e a Possibilidade de uma IA Sem Viés

A Inteligência Artificial Geral (AGI, na sigla em inglês) representa um avanço além das IAs atuais, que são especializadas em tarefas específicas. Diferente dessas IAs limitadas, a AGI teria a capacidade de aprender, raciocinar e tomar decisões de forma semelhante à inteligência humana, adaptando-se a diferentes contextos sem precisar ser reprogramada.

Diante disso, surge uma questão fundamental: seria possível que a AGI fosse totalmente isenta de viés?

Em teoria, uma AGI avançada poderia analisar múltiplas perspectivas, avaliar a veracidade das informações e até reconhecer e corrigir seus próprios vieses. Diferente das IAs atuais, que são treinadas com dados fixos e podem perpetuar distorções, uma AGI sofisticada poderia desenvolver mecanismos para questionar e validar informações de forma autônoma, buscando um equilíbrio mais próximo da imparcialidade.

Por outro lado, a verdadeira neutralidade pode ser ilusória. Mesmo uma AGI altamente desenvolvida ainda dependeria dos dados que recebe, das regras que são estabelecidas para sua operação e das intenções de quem a cria. Se uma AGI for desenvolvida sob um conjunto específico de valores ou sob a influência de um governo ou empresa, sua "objetividade" pode ser limitada pelas diretrizes que guiam seu aprendizado.

Além disso, o próprio conceito de imparcialidade é subjetivo. O que uma cultura considera como "justo" pode ser interpretado de forma diferente por outra. Se a AGI precisar tomar decisões éticas e morais, em quem ou em que valores ela se basearia?

A verdade é que, mesmo com uma AGI avançada, eliminar completamente o viés pode ser impossível. No entanto, um modelo de AGI bem projetado poderia minimizar vieses muito mais do que as IAs atuais, buscando transparência, diversidade de fontes e processos contínuos de autoavaliação.

Se conseguirmos construir uma AGI que seja capaz de reconhecer vieses e corrigir-se em tempo real, podemos nos aproximar de um sistema de inteligência artificial mais justo e confiável. Mas até lá, a melhor defesa contra os vieses da IA continua sendo a mesma: o pensamento crítico humano.