Tamanho é Documento no Mundo da IA?

Algoritmos com menos "neurônios" e de baixo custo estão se mostrando tão eficientes quanto modelos muito maiores e mais caros.

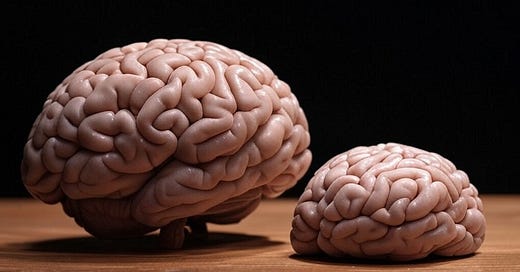

Por muito tempo, acreditava-se que, para uma inteligência artificial ser realmente boa, ela precisava ser gigante. Mais parâmetros (ou seja, os "neurônios" da IA) significavam mais inteligência. Se um modelo de IA tivesse 100 bilhões de parâmetros, ele deveria ser mais poderoso do que um modelo com 10 bilhões, certo?

Bom... não é bem assim.

O que são os parâmetros e por que eles importam?

Os parâmetros de um modelo de IA funcionam como os pequenos ajustes que permitem que ele aprenda. Pense neles como os "botões" de uma televisão antiga: você pode ajustar o brilho, o contraste e o volume até encontrar a melhor configuração. Em IA, cada parâmetro é um desses ajustes.

A ideia era que quanto mais parâmetros um modelo tivesse, mais informações ele poderia armazenar e processar, tornando-o mais inteligente. Mas recentemente, as empresas chinesas de IA descobriram que o número de parâmetros por si só não é o fator mais importante. Um modelo menor pode ser tão eficiente quanto um maior se for treinado corretamente e utilizar técnicas modernas de otimização.

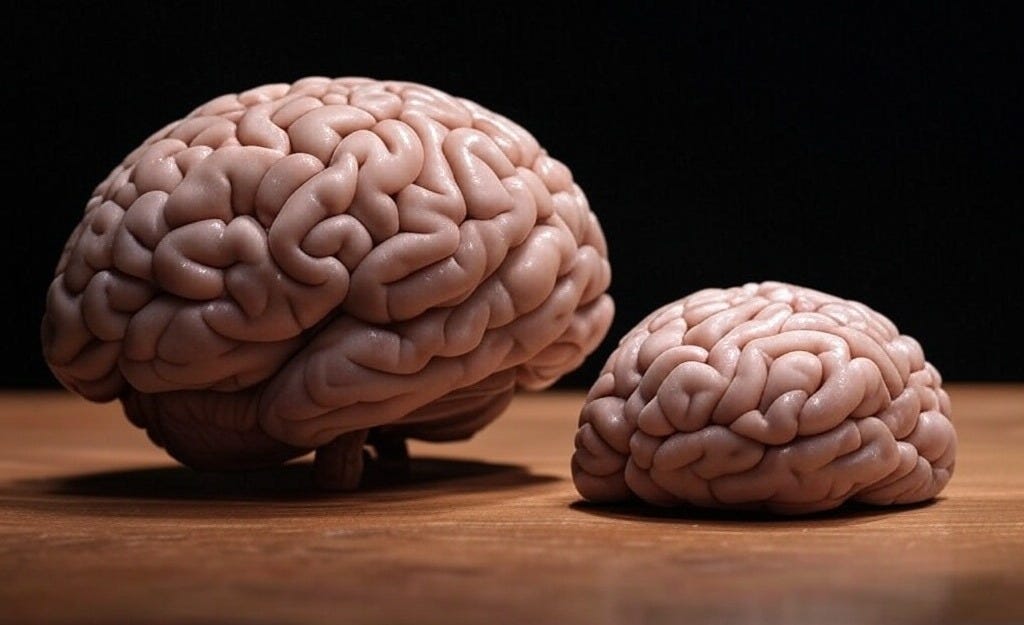

O caso do QwQ-32B vs. DeepSeek-67B

Um exemplo perfeito disso é o novo modelo da Alibaba, o QwQ-32B, que tem "apenas" 32 bilhões de parâmetros. Isso parece muito, mas é quase 20 vezes menor que o DeepSeek, que tem 671 bilhões de parâmetros. A parte surpreendente? Ambos têm um desempenho semelhante!

Isso quebra um grande mito da IA: tamanho não é tudo. O que realmente importa é como o modelo foi treinado, o tipo de arquitetura que ele usa e as técnicas de otimização. Com métodos mais inteligentes, é possível ensinar uma IA a pensar de forma eficiente sem precisar de um número absurdo de parâmetros.

Como um modelo menor pode ser tão bom quanto um gigante?

Aqui estão algumas razões:

Treinamento mais inteligente: Novas técnicas, como aprendizado reforçado e pré-treinamento mais eficiente, ajudam modelos menores a aprenderem mais com menos.

Uso otimizado de parâmetros: Em vez de espalhar o conhecimento por milhões de neurônios que nem sempre são úteis, modelos modernos focam nos parâmetros que realmente fazem diferença.

Eficiência computacional: Modelos menores gastam menos energia e custam menos para rodar, o que os torna mais acessíveis para empresas e usuários.

Menos custo, mais eficiência

Outro fator importante é o custo. Grandes modelos exigem enormes “fazendas” de servidores para serem treinados e operados. A Meta, por exemplo, deve gastar mais de US$ 200 bilhões em infraestrutura de IA nos próximos anos. Já a Alibaba pretende investir US$ 52,4 bilhões, o que é um valor alto, mas ainda assim bem menor.

Se um modelo menor consegue fazer o mesmo trabalho que um maior por uma fração do custo, quem você acha que vai ganhar no longo prazo?

O futuro da IA: Pequeno, mas poderoso

O desenvolvimento do QwQ-32B mostra que estamos entrando em uma nova era da IA, onde inteligência não significa apenas tamanho, mas também eficiência. Modelos menores, mais rápidos e mais baratos podem ser tão bons (ou até melhores) que os gigantes do passado.

Isso significa que a IA está ficando mais acessível, mais barata e mais eficiente. E no fim das contas, essa é a verdadeira revolução: modelos mais inteligentes, consumindo menos energia e entregando resultados cada vez melhores.

O que você acha? O futuro da IA será dominado pelos gigantes ou pelos modelos mais ágeis e otimizados?